L'exploit technologique qui a bouleversé la direction d'OpenAI et, peut-être, l'intelligence artificielle

Pourquoi le projet Q* a-t-il mené à l'éviction puis au retour de Sam Altman comme DG d'OpenAI, un an après le lancement de ChatGPT ? Parce qu'il s'agit d'une puissante découverte en intelligence artificielle qui pourrait menacer l'humanité, selon une lettre de plusieurs chercheurs de l'entreprise, adressée au conseil d'administration d'OpenAI, dont les contenus essentiels ont été révélés par l'agence Reuters et le média spécialisé The Information. Dans une interview accordée quelques semaines après à une autre publication spécialisée, The Verge, Sam Altman qualifie cette information de « fuite malheureuse », mais ne la dément pas ; au contraire, il la confirme : « nous nous attendons à ce que les progrès de cette technologie continuent à être rapides et que nous travaillions très dur pour comprendre comment la rendre sûre et bénéfique ».

« OpenAI ne dispose pas des garde-fous adéquats pour commercialiser des modèles d'intelligence artificielle aussi avancés » ont écrit certains employés dans la lettre au conseil d'administration, selon The Information. D'après ces sources, grâce à ses énormes ressources informatiques, le nouveau modèle Q* est capable de résoudre certains problèmes mathématiques. Bien qu'il ne réalise que des opérations mathématiques au niveau des élèves du primaire, la réussite de ces types de tests a rendu les chercheurs très optimistes quant au futur succès de Q*. Contrairement à une calculatrice qui peut résoudre un nombre limité d'opérations, cette intelligence artificielle peut généraliser, apprendre et comprendre.

Les chercheurs considèrent que les mathématiques sont la frontière du développement de l'IA. Actuellement, l'IA générative est bonne pour écrire et traduire des langues par la prédiction statistique du mot suivant, comme dans ChatGPT. Les réponses à une même question peuvent énormément varier. Mais conquérir la capacité de faire des calculs mathématiques où il n'y a qu'une seule réponse correcte implique que l'IA aurait une plus grande capacité de raisonnement qui se rapprocherait de l'intelligence humaine. Cela pourrait s'appliquer, par exemple, à la recherche scientifique, croient les chercheurs en intelligence artificielle.

Les informaticiens débattent depuis longtemps sur le danger que représentent les machines super intelligentes, si elles envisageaient, par exemple, que leur intérêt serait la destruction de l'humanité. Au conseil d'OpenAI, il y avait deux personnes très sensibles à ces risques, qui ont démissionné dans le cadre de l'accord pour le retour d'Altman. Selon la lettre que les employés ont envoyée au conseil demandant leur démission, ces indépendants ont transmis aux dirigeants que permettre la destruction de l'entreprise pourrait être cohérent avec leur mission en faveur de l'humanité.

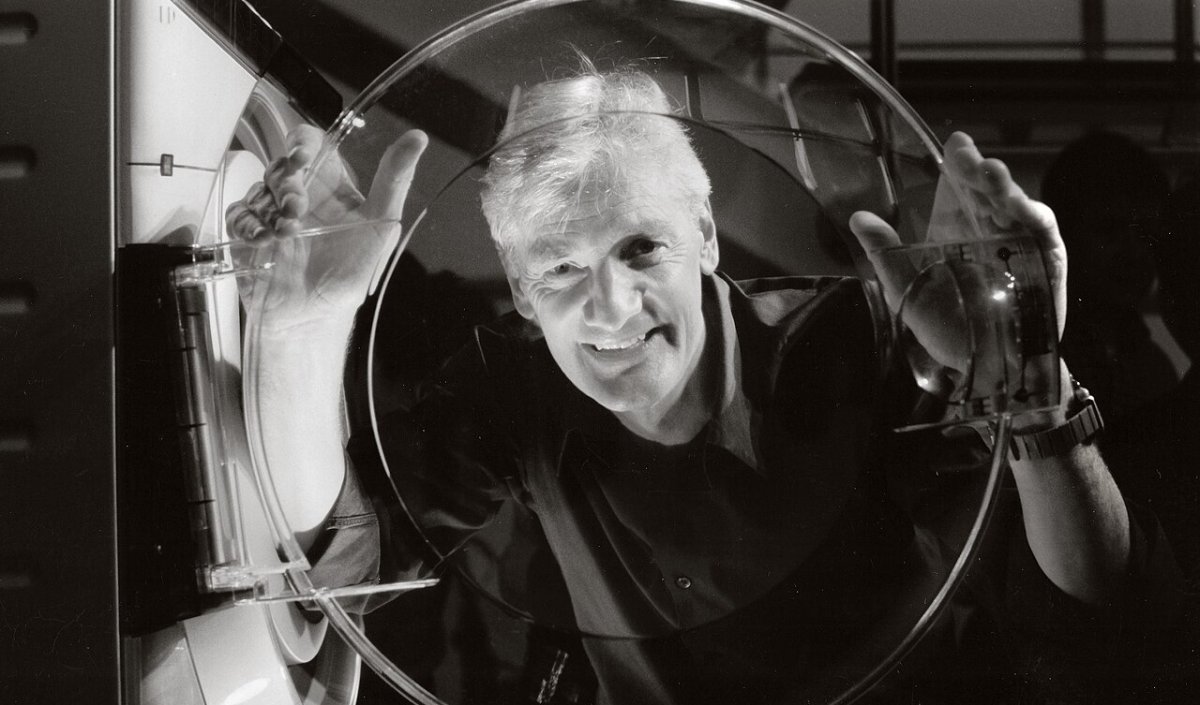

Mais, si nous laissons de côté les rumeurs informatives, que peut savoir en ce moment la communauté scientifique sur cette potentielle avancée d'OpenAI ? C'est à cette question qu'a répondu, dans le magazine Forbes, l'un des experts les plus reconnus en intelligence artificielle, Lance B. Eliot, ancien professeur de l'Université de Californie, directeur d'un laboratoire pionnier en intelligence artificielle, auteur de plus de 50 livres sur la matière, et conseiller du Congrès des États-Unis. En particulier, Eliot se demande si cette avancée constitue un pas significatif vers l'intelligence artificielle générale (IAG), décrite par les experts comme capable d'effectuer ou d'apprendre pratiquement toute tâche cognitive typiquement humaine.

D'après les informations disponibles, Eliot pense que tout semble indiquer que Q* aurait pu intégrer une forme de raisonnement mathématique plus avancée dans son cadre d'intelligence artificielle. Il n'a pas atteint l'IAG, considère-t-il, mais cela permet de comprendre comment progresser vers elle. Cet objectif, selon Eliot, pourrait avoir été atteint grâce à la Test-Time Computation (TTC), permettant une plus grande généralisation et adaptabilité dans la résolution de problèmes.

Eliot conclut en posant des questions éthiques, en particulier, il se demande si les entreprises d'intelligence artificielle devraient être obligées de partager leurs découvertes significatives pour éviter des problèmes éthiques. « Est-il juste pour une entreprise qui a dépensé ses ressources pour concevoir une percée en IA de ne pas en tirer profit et de devoir simplement la remettre au grand public ? ». « Ce sont des questions sérieuses et graves. La société doit déterminer ce que nous voulons faire. Une des préoccupations est que si ces questions ne sont pas abordées en temps opportun, peut-être que le cheval sortira de l'écurie, et nous ne serons pas prêts pour les conséquences », conclut Eliot.